AWS Step Functions VS

Adds Support for Nested Workflows

Adds Support for Nested Workflows

/etc/systemd/system/docker.service.d/https-proxy.conf

[Service]

Environment="http_proxy=http://127.0.0.1:8123" "https_proxy=https://127.0.0.1:8123" "NO_PROXY=registry-1.docker.io"

sudo systemctl daemon-reload

sudo systemctl restart docker

/etc/default/docker

export http_proxy="http://127.0.0.1:3128/"

/etc/docker/daemon

~/.docker/config.json

"proxies":{

"default":{}

}

软件接口 OPC

应用层 ModBus

数据链路层 CAN,ProfiBus

物理层 RS232,RS485

OPC SERVER = OPC驱动器

简单来说,OPC是一套标准,其目的是把PLC特定的协议(如Modbus,Profibus等)抽象成为标准化的接口,作为“中间人”的角色把通用的OPC“读写”请求转换成具体的设备协议来与HMI/SCADA系统直接对接

When the standard was first released in 1996, its purpose was to abstract PLC specific protocols (such as Modbus, Profibus, etc.) into a standardized interface allowing HMI/SCADA systems to interface with a “middle-man” who would convert generic-OPC read/write requests into device-specific requests and vice-versa.

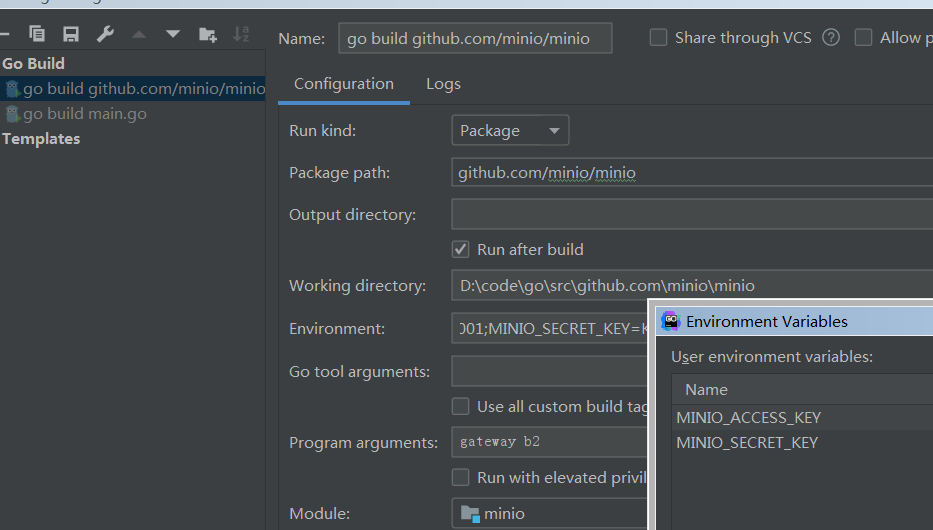

下载B2 TLS安全证书

openssl s_client -showcerts -connect api.backblazeb2.com:443 > b2.crt

mv b2.crt .minio/certs/CAs/

set MINIO_ACCESS_KEY=B2_keyID

set MINIO_SECRET_KEY=B2_applicationKey

minio gateway b2

之前一直用pycharm,今天把code升级到1.3.2的时候, 突然提示我安装python扩展,决定试试。 结果发现python的解释器设置有问题, 总是设置为系统的解释器, 而虚拟环境的解释器不起作用。

apt remove --purge python3.5

reboot

结果ubuntu桌面启动不了。好多应用程序例如chrome,virtualbox都消失了, 造成了很大的麻烦。

Ctrl+Alt+F1进入虚拟控制台登录

apt install python3.5

apt install ubuntu-desktop

重新安装chrome和virtualbox

cd /etc/apt/sources.list.d

sudo mv google-chrome.list.save google-chrome.list

apt update

apt install google-chrome-stable

git clone [email protected]:wubigo/kubernetes.git

git remote add upstream https://github.com/kubernetes/kubernetes.git

git fetch --all

git checkout tags/v1.13.3 -b v1.13.3

git branch -av|grep 1.13

* fix-1.13 4807084f79 Add/Update CHANGELOG-1.13.md for v1.13.2.

remotes/origin/release-1.13 4807084f79 Add/Update CHANGELOG-1.13.md for v1.13.2.

func (kl *Kubelet) syncPod(o syncPodOptions) error {

基于腾讯云Go SDK开发

go get -u github.com/tencentcloud/tencentcloud-sdk-go

从本地开发集群K8S读取安全凭证secretId和secretKey配置信息, 然后把安全凭证传送给SDK客户端

secretId, secretKey:= K8SClient.Secrets("namespace=tencent").Get("cloud-pass")

credential := CloudCommon.NewCredential("secretId", "secretKey")

client, _ := cvm.NewClient(credential, regions.Beijing)

request := cvm.NewAllocateHostsRequest()

request.FromJsonString(K8SClient.Configs("namespace=tencent").Get("K8S-TENCENT-PROD"))

response, err := client.AllocateHosts(request)

Ansible.Hosts().Get(response.ToJsonString())

调用ANSIBLE开始在CVM部署K8S集群

转录语音数据集

mozilla crowdsources the largest dataset of human voices available for use, including 18 different languages, adding up to almost 1,400 hours of recorded voice data from more than 42,000 contributors